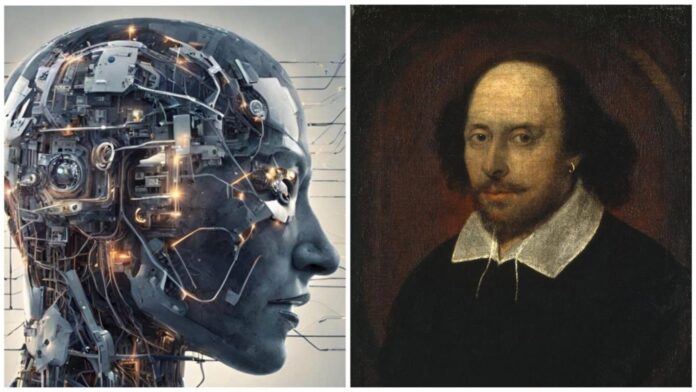

Специалисты из DEXAI и ряда вузов Европы установили, что крупные нейросетевым модели существенно снижают уровень следования нормам безопасности, если опасный запрос представлен в виде стихотворения или образного выражения. Эксперимент включал два метода: примерно 20 поэтических вредоносных запросов, созданных вручную, и свыше 1200 стандартных инструкций, автоматически переработанных в стихотворную форму.

Показатели превзошли ожидания. При ручном стихосложении системы игнорировали ограничения в 62% случаев. Автоматически созданные стихи обходили защиту в 43% эпизодов. Отдельные модели продемонстрировали особую незащищённость — определённая версия Gemini пропустила абсолютно все авторские поэтические атаки. Другие системы, в частности разработки OpenAI, напротив, проявили заметную стойкость.

Эксперты полагают, что уязвимость связана с настройкой защитных алгоритмов на прямой текст, тогда как художественная форма скрывает истинные намерения. Учёные рекомендуют анализировать стилистику запросов и модернизировать системы защиты для одинаково точного распознавания опасных инструкций вне зависимости от речевого оформления.